ملخص تنفيذي

في ظل المنافسة المتزايدة، تسعى المؤسسات إلى تدريب نماذج الذكاء الاصطناعي على بيانات حساسة. لكن ماذا لو أصبحت هذه النماذج، التي تبدو غير ضارة، بوابة للمهاجمين؟

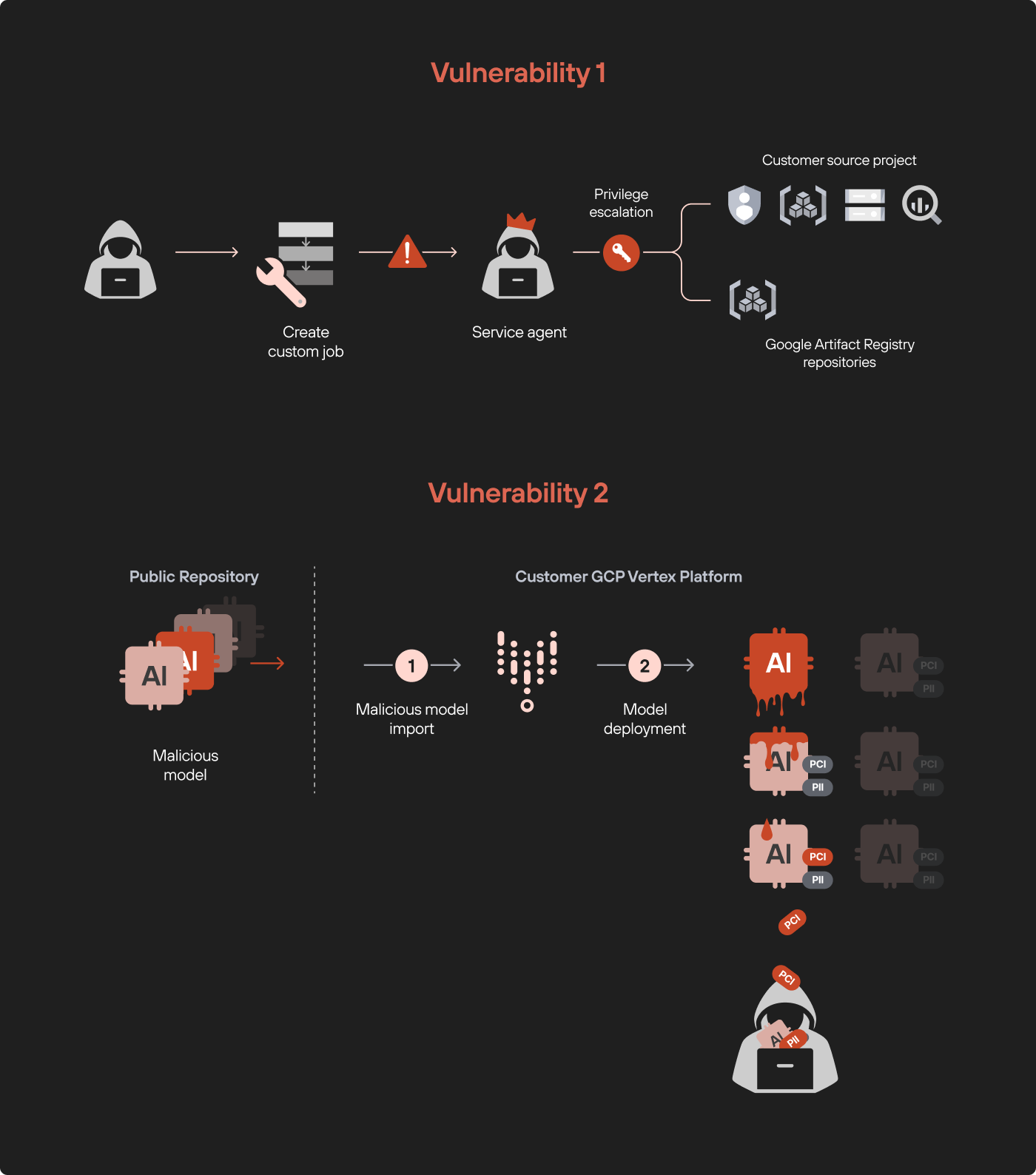

كشفت أبحاث شركة Palo Alto Networks عن ثغرتين في منصة Vertex AI من Google، كانتا ستسمحان للمهاجمين بتصعيد الامتيازات وسرقة النماذج. هذه الثغرات تمثل تهديدًا كبيرًا لأمان البيانات، حيث يمكن أن يؤدي استغلالها إلى تسرب معلومات حساسة.

تفاصيل الثغرات المكتشفة

1. تصعيد الامتيازات عبر الوظائف المخصصة: تمكن الباحثون من استغلال أذونات الوظائف المخصصة للوصول غير المصرح به إلى جميع خدمات البيانات في المشروع.

2. سرقة النماذج عبر نموذج خبيث: أدى نشر نموذج ملوث في Vertex AI إلى تسرب جميع النماذج المدربة الأخرى، مما يعرض البيانات الحساسة للخطر.

كيف تعمل هذه الثغرات؟

- تصعيد الامتيازات: من خلال استغلال أذونات الوظائف المخصصة، تمكن الباحثون من الوصول إلى بيانات لم يكن ينبغي لهم الوصول إليها، مثل ملفات التخزين وقواعد البيانات.

- نموذج خبيث: يمكن لمهاجم تحميل نموذج ملوث إلى مستودع عام، وعند استيراده من قبل موظف غير مدرك للخطر، يمكن أن يؤدي ذلك إلى تسرب نماذج أخرى في البيئة.

التوصيات لحماية البيانات

توصي شركة Palo Alto Networks المؤسسات باتخاذ تدابير وقائية، مثل:

- مراجعة الأذونات: التأكد من أن الأذونات المعطاة للوظائف المخصصة محدودة ولا تمنح وصولاً غير ضروري.

- التأكد من صحة النماذج المستوردة: يجب على الفرق الفنية التحقق من مصدر النماذج قبل استخدامها.

- استخدام أدوات الحماية: الاستفادة من حلول الأمان السحابية مثل Prisma Cloud لحماية البيئة السحابية من التهديدات المحتملة.

في الختام، تبرز هذه الأبحاث أهمية حماية البيانات في بيئات الذكاء الاصطناعي، حيث يمكن أن يؤدي استغلال ثغرة واحدة إلى عواقب وخيمة على الأمن السيبراني للمؤسسات.